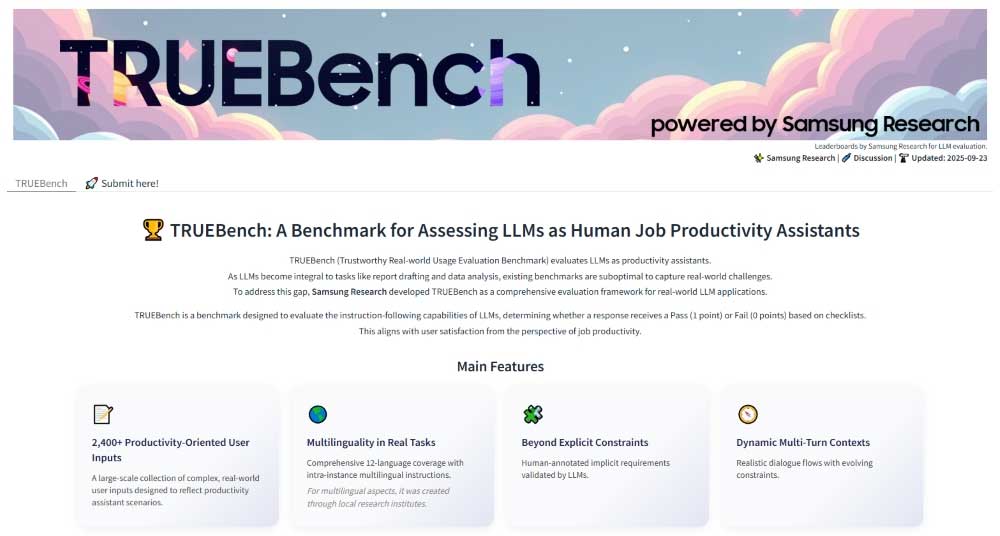

Samsung zaprezentował TRUEBench (Trustworthy Real-world Usage Evaluation Benchmark) - własny benchmark opracowany przez Samsung Research w celu oceny produktywności AI.

TRUEBench zapewnia kompleksowy zestaw wskaźników do pomiaru wydajności dużych modeli językowych (LLM) w rzeczywistych zastosowaniach związanych z produktywnością w miejscu pracy. Aby zapewnić realistyczną ocenę, uwzględnia różnorodne scenariusze dialogowe i warunki wielojęzyczne.

TRUEBench ocenia często wykonywane zadania w przedsiębiorstwach — takie jak generowanie treści, analiza danych, streszczanie i tłumaczenie — w 10 kategoriach i 46 podkategoriach.

Istniejące testy porównawcze mierzą głównie ogólną wydajność, są w większości skoncentrowane na języku angielskim i ograniczają się do struktur pytań i odpowiedzi typu single-turn. Ogranicza to ich zdolność do odzwierciedlania rzeczywistych środowisk pracy.

TRUEBench składa się z łącznie 2485 zestawów testowych w 10 kategoriach i 12 językach (chiński, angielski, francuski, niemiecki, włoski, japoński, koreański, polski, portugalski, rosyjski, hiszpański i wietnamski) — obsługując jednocześnie scenariusze międzyjęzykowe. Zestawy testowe sprawdzają, co modele AI mogą faktycznie rozwiązać, a Samsung Research zastosował zestawy testowe o długości od 8 do ponad 20 000 znaków, odzwierciedlające zadania od prostych żądań po długie streszczenia dokumentów.

Samsung Research zweryfikował elementy oceny poprzez współpracę między ludźmi a AI. Najpierw ludzie tworzą kryteria oceny, a następnie sztuczna inteligencja sprawdza je pod kątem błędów, sprzeczności lub niepotrzebnych ograniczeń. Następnie ludzie ponownie udoskonalają kryteria, powtarzając ten proces w celu zastosowania coraz bardziej precyzyjnych standardów oceny. Na podstawie tych wzajemnie zweryfikowanych kryteriów przeprowadzana jest automatyczna ocena modeli sztucznej inteligencji, minimalizując subiektywne uprzedzenia i zapewniając spójność. Ponadto, aby model przeszedł test, muszą być spełnione wszystkie warunki. Umożliwia to bardziej szczegółową i precyzyjną ocenę wszystkich zadań.

Próbki danych i tabele wyników TRUEBench są dostępne na globalnej platformie open source Hugging Face, która pozwala użytkownikom porównać maksymalnie pięć modeli i umożliwia kompleksowe porównanie wydajności modeli AI na pierwszy rzut oka. Ponadto publikowane są również dane dotyczące średniej długości wyników odpowiedzi, co umożliwia jednoczesne porównanie zarówno wydajności, jak i efektywności.